元?インフラエンジニアと言い始めてから5か月…。

現在、DX推進の営業技術屋としてお仕事しておりますが、DXにも色々ありまして、当初はIoT系を色々やっておりましたが、気が付いたら・・・インフラ界隈のお仕事も結構やっております…(^^;AzureがどうとかOffice365がどうとかブログで書いている時点で何しているの?という感じではありますが。こんなことやっている間にWVD設計進めろよ・・・という感じではあるのですが、DXだけじゃなくハイブリッドなインフラ屋としての活動もして行く感じっすね。

さて、昨年頃からガートナーさんあたりがサシーがどうのという事で、ちらっと耳にはしていたのですが、SASEとは「Secure Access Service Edge」といって、簡単に言うと、クラウド時代のオールインワンな詰め合わせ・・・なのでちょっとSASEで意味先行しすぎちゃうと意味わからなくなるかもですが、一時ファイアウォールでも統合型~やら次世代~とかありましたね。その次なる世界です。今時にいうと統合系では第3世代ぐらい?(ちょっとわからないけど)。

んで、なんでSASEなんかというと「DXやるのにインフラ(セキュリティも含む)が色々複雑で足手まといなんだよっ」というのが、今までのインフラという事みたいですね。ハイブリッドクラウドも含めて。端的に言うとですが。

こんなコロナやらテレワークやらで、インターネットが主戦場で、結局ミーティング品質悪ぃしぃ・・・意味不明な遅さや重さに悩まされるし?どれが悪いのか複雑だからわかりづらいし?自宅環境なんて何それ?だし。5Gは来ないし?BYODなんてかっこいいこと言ってセキュリティ度返しだし?コントロール大変だし?社員信用できなくて疑心暗鬼だし?もっとスマートにやれないのかよっ・・・という所でSD-WANから先のソリューションの位置づけなのかな、回線屋もネットワーク屋もセキュリティ屋もDX屋も情シス?もハッピーになれそうな?エコシステムなソリューションがSASEってところでしょうか(ザックリですが)。

そういった中でのSASEという言葉がガートナーさんで提唱された頃に、「あ、それ作ってました~」というのがCato Networksさんぽいっすね。他調べ切れてませんけど。

バックボーンはMPLS品質のワールドワイドに展開されて、各PoPというポイントに繋げば、整備されたアウトバーンを決めた速度で使い放題という製品。このPoPへのエッジからの接続から、各クラウドとの接続、網内から各クラウドサービスへの接続を、最寄のPoPから最短ルートで出口へ案内してくれるという。昔で言うとIP-VPNとかで色々がばって接続していたのが、もっとフレキシブルに短時間で開通させられて、更にセキュリティもやれちゃうってことですね。構築のリードタイムはかなーり早くなるという。

専用線引き込むのに結構苦労したりするんですけど、インターネット回線でPoPに繋げればOKなので、ラスト1マイルの品質を気にする必要はありますが、そこはSD-WANがカバーという事なのでしょう。

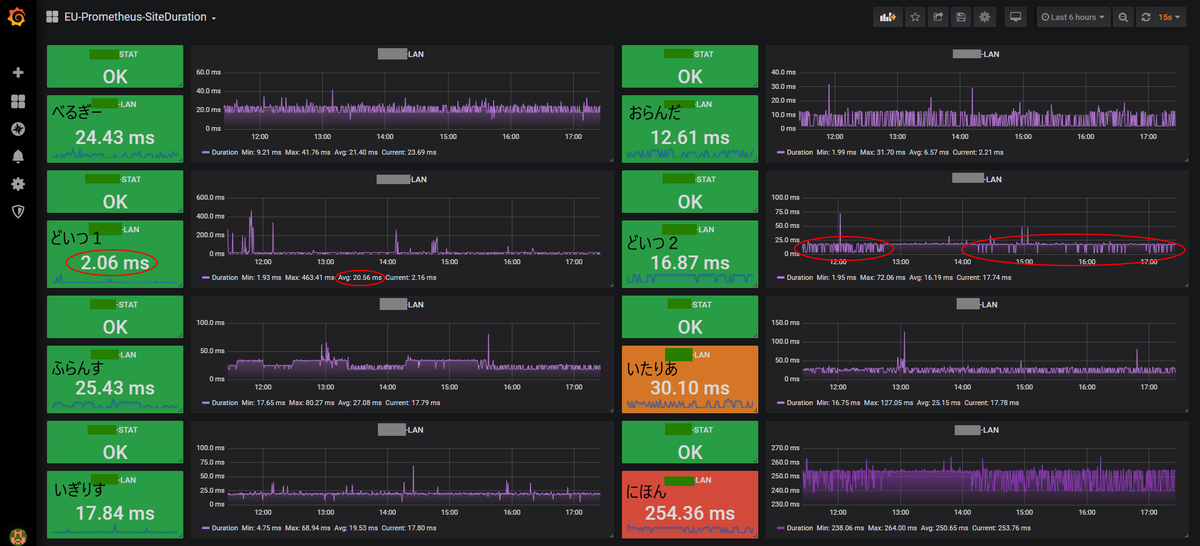

インターネットは速度制限こそ殆ど無いのですが荒れ道ですからね・・・私もインターネットの品質管理・品質監視には結構研究してトライしてきました。改善も色々手を尽くしましたけど、尽くせないこともありました。5Gなんかもそうですが、制限速度がない世界は結局輻輳を起こしてふんずまって渋滞して、出直し率(再送)が上がってスループットが安定しないんすよね。ラストワンマイルだけが頑張ったって、目的地までが綺麗な道なだけとは限らない。時間帯によって変わるし。そこに要らん攻撃もあるしね・・・。綺麗な整備された道から荒れ道の区間を最小限にすれば結構効果あるかもね。てことで、あれこれ散らかっていたものをスマートに統合しちゃってDXしようZE・・・。

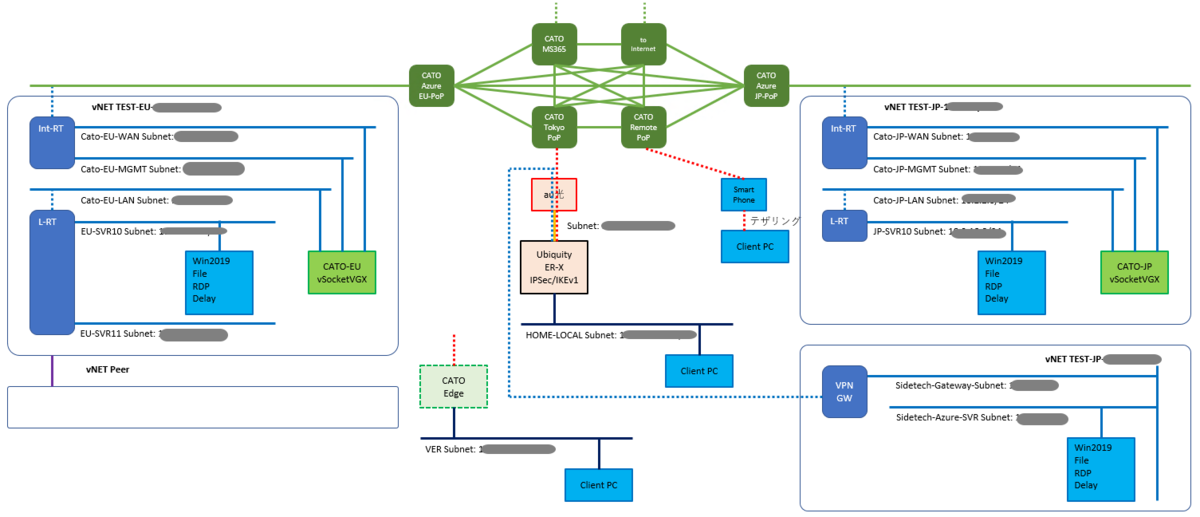

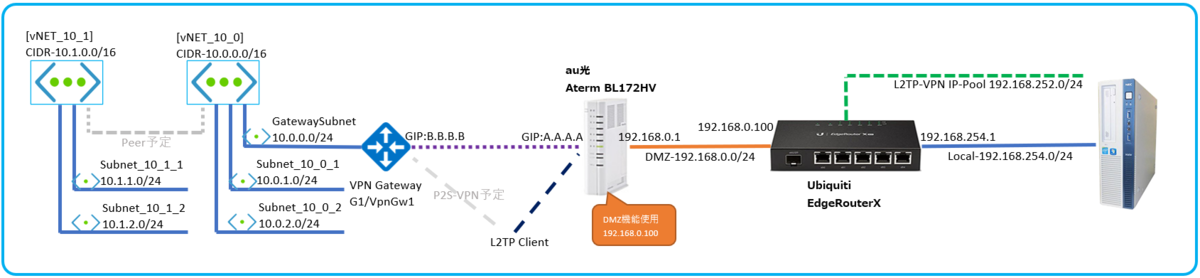

てことで、今は以下の様な感じです。

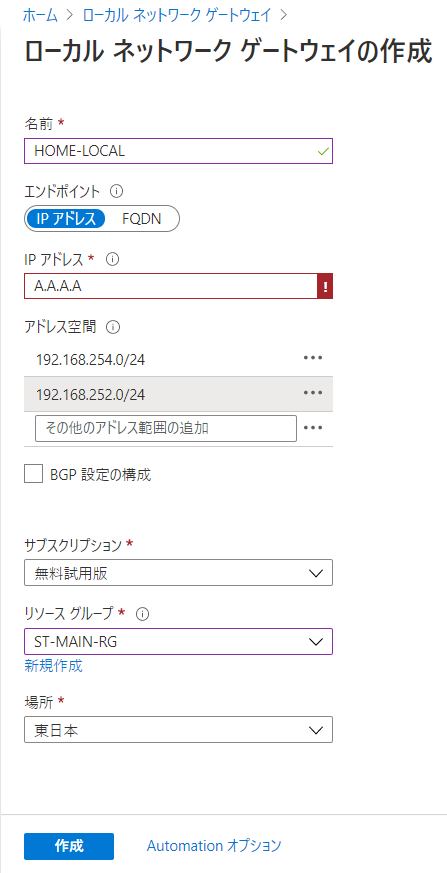

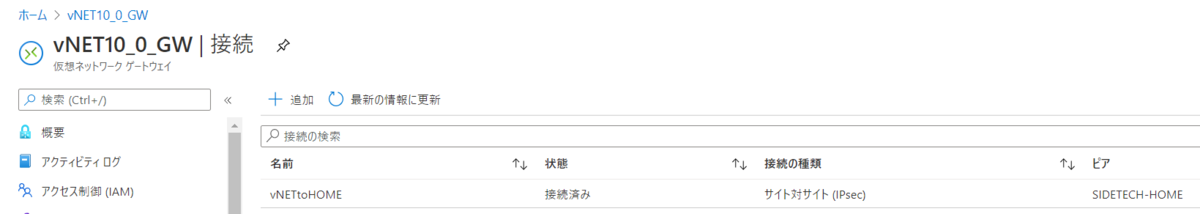

自宅(笑)とAzureを結んでいる様に見えるでしょ。

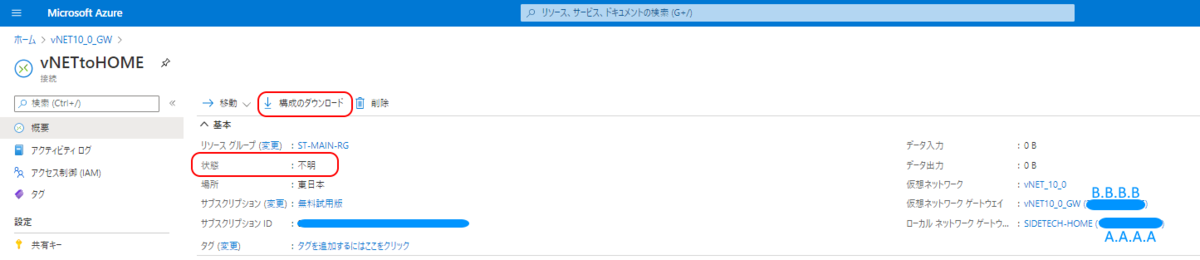

まだ、ルーティングの設計までは終わってないんだけど、なんとかデプロイしてオンラインまでは持っていきました。5時間弱程度でしょうか。ちょっと予習しつつトライしつつだったもんで。慣れればもう少しタイムアップするかな?

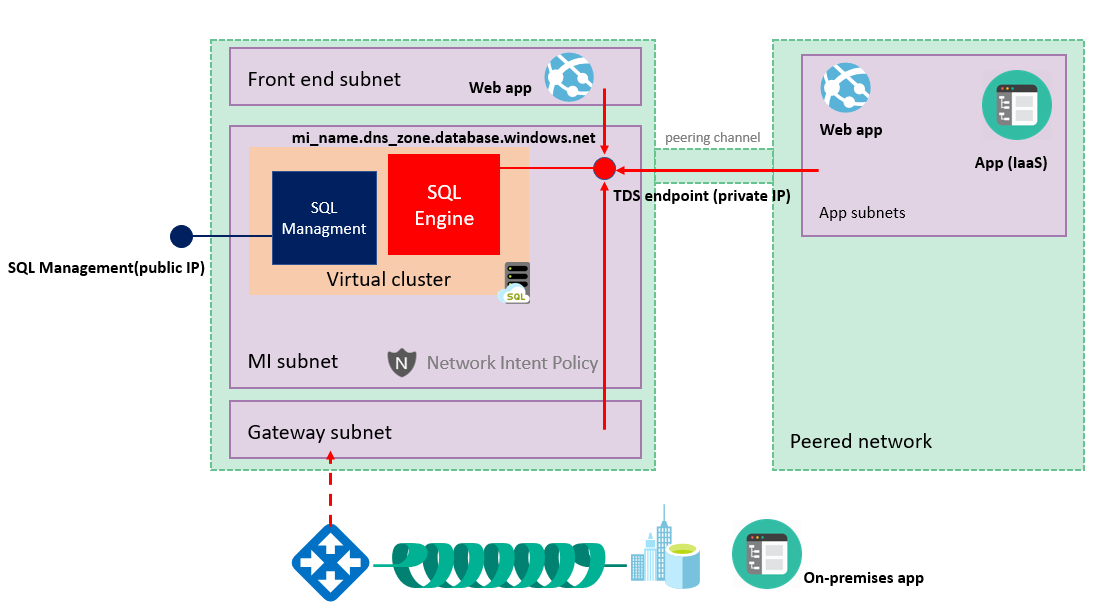

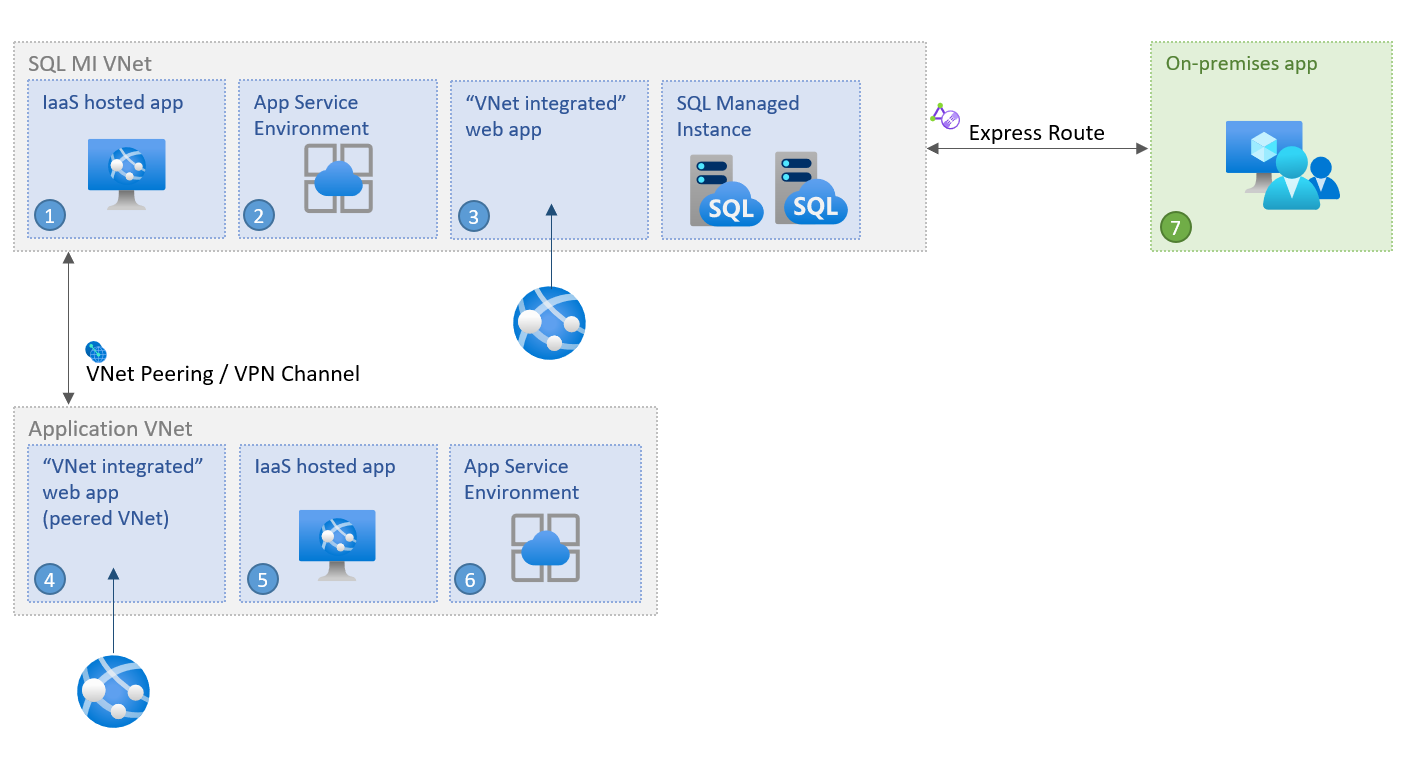

てことで、私のAzureとCatoの評価期間の問題もあるので、以下の私が想定したPoCをサクッとやっつけていくっ。まだやりながら設計しただけなので、ちょっとこまい所決めていないけど、大体これぐらいで大半の事はOKなはず。

シナリオは、色々沢山立てたのですが・・・出来ないと恥ずかしいので、出来たものからアップしていきますね。

【今現在やったもの】

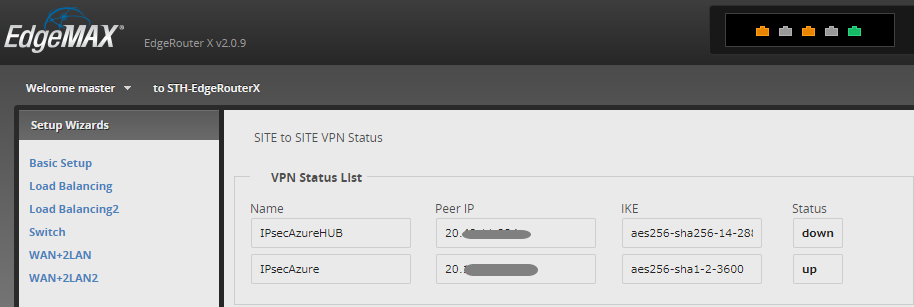

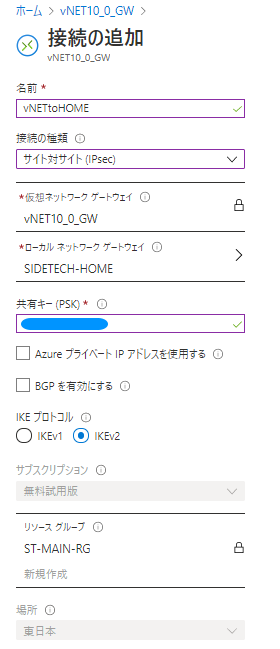

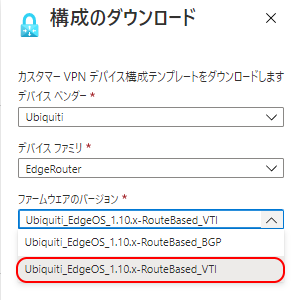

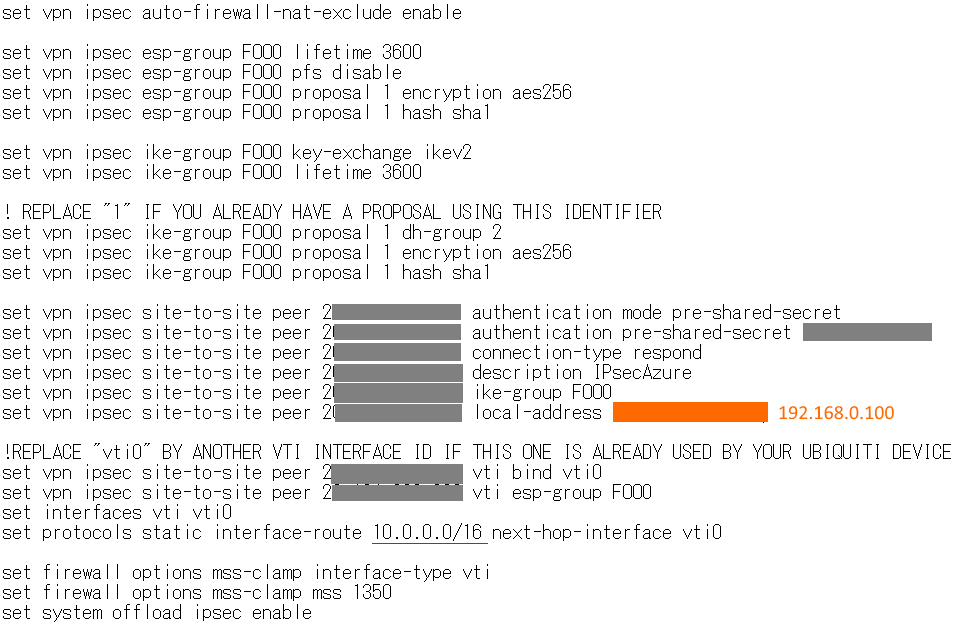

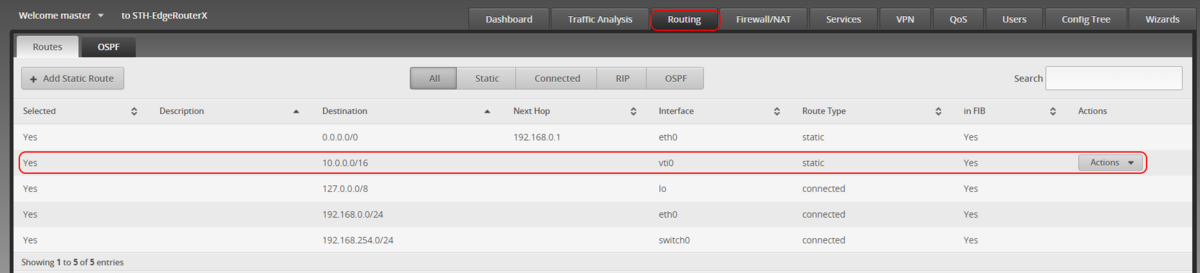

・Ubiquity ER-XでIPSec IKEv2でPoPにVPN張る

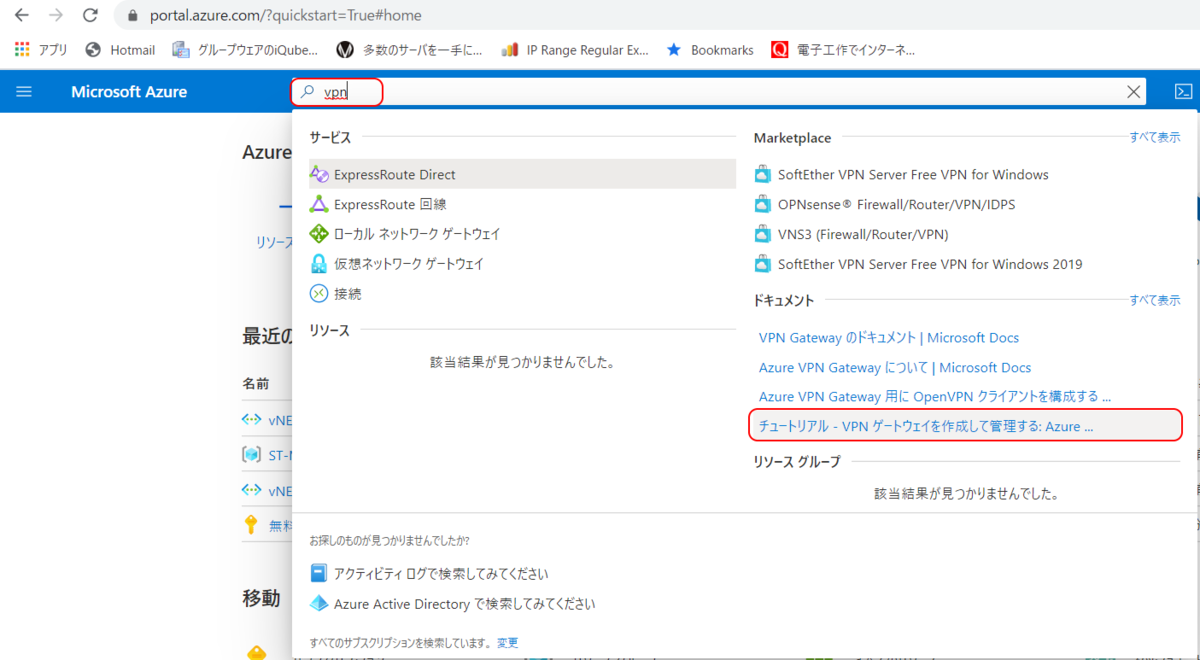

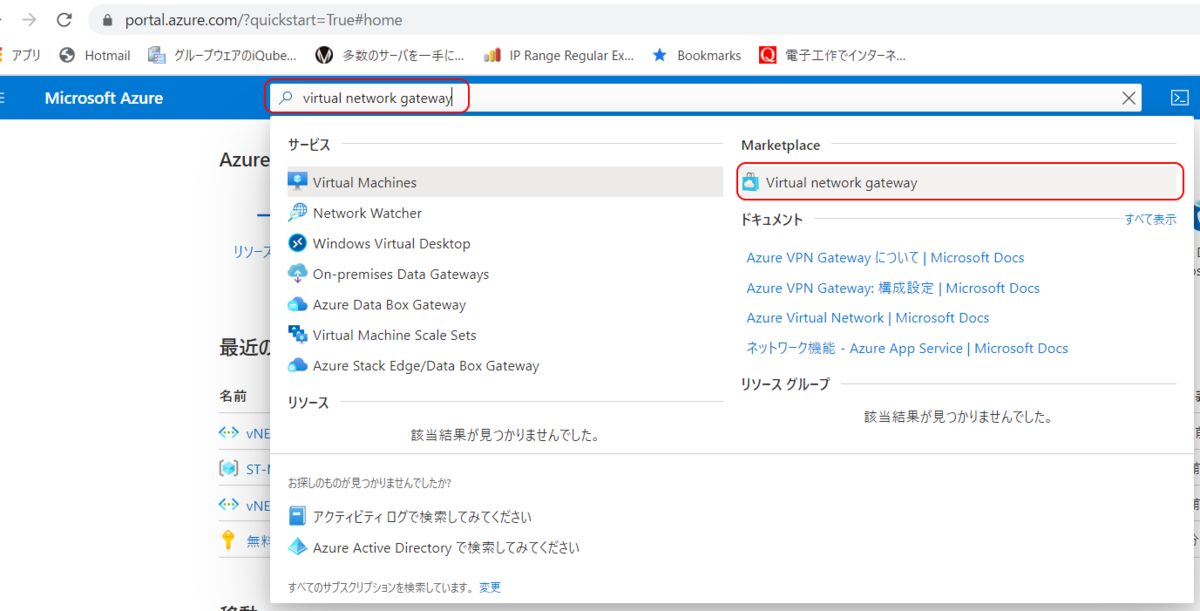

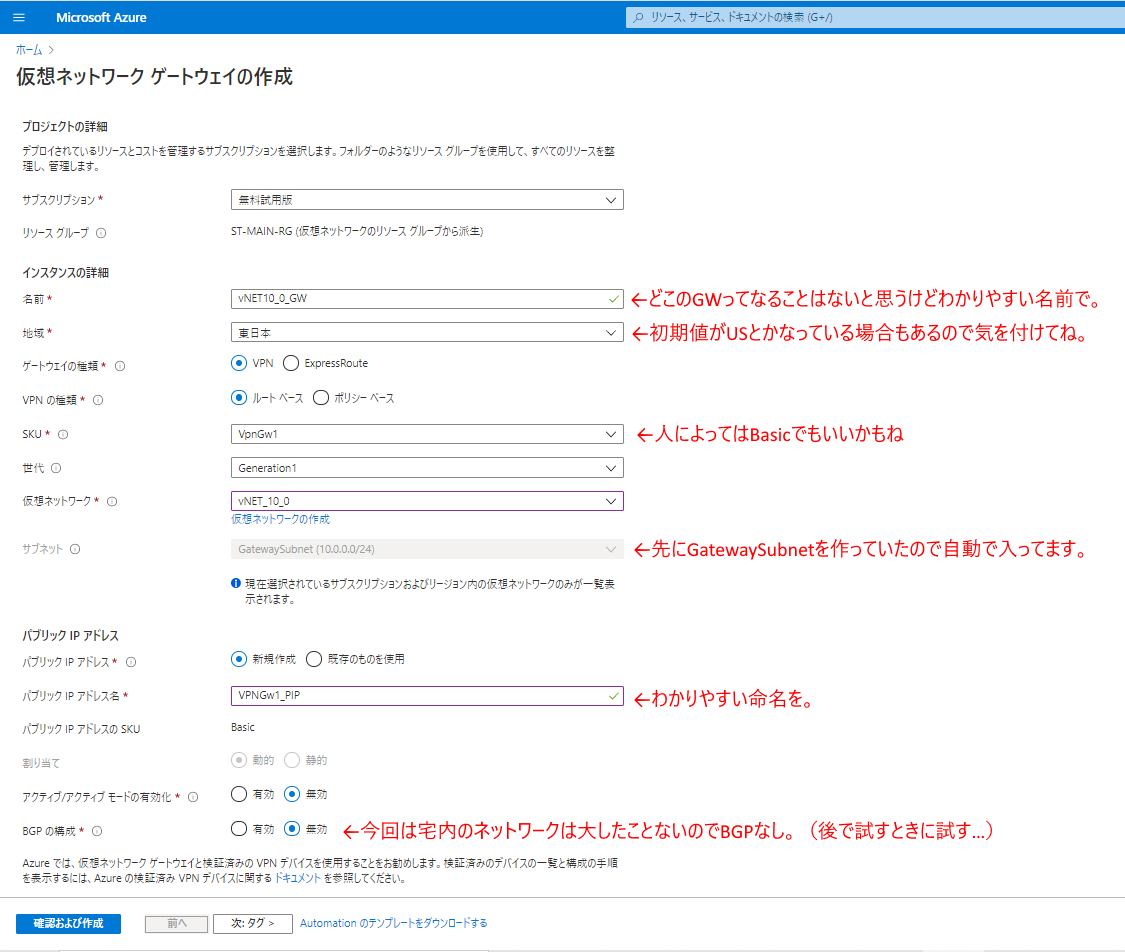

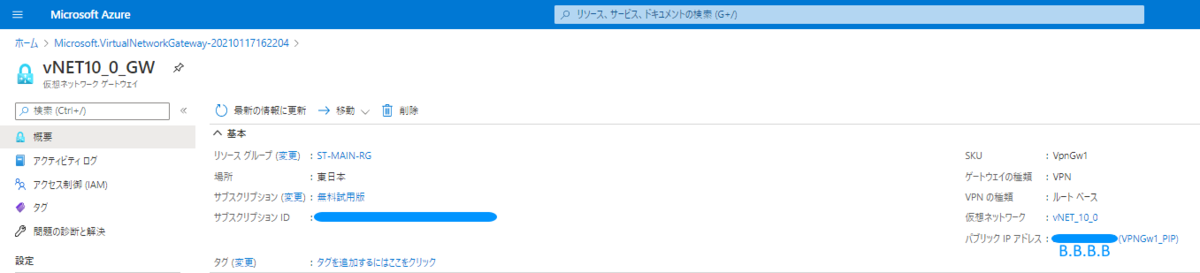

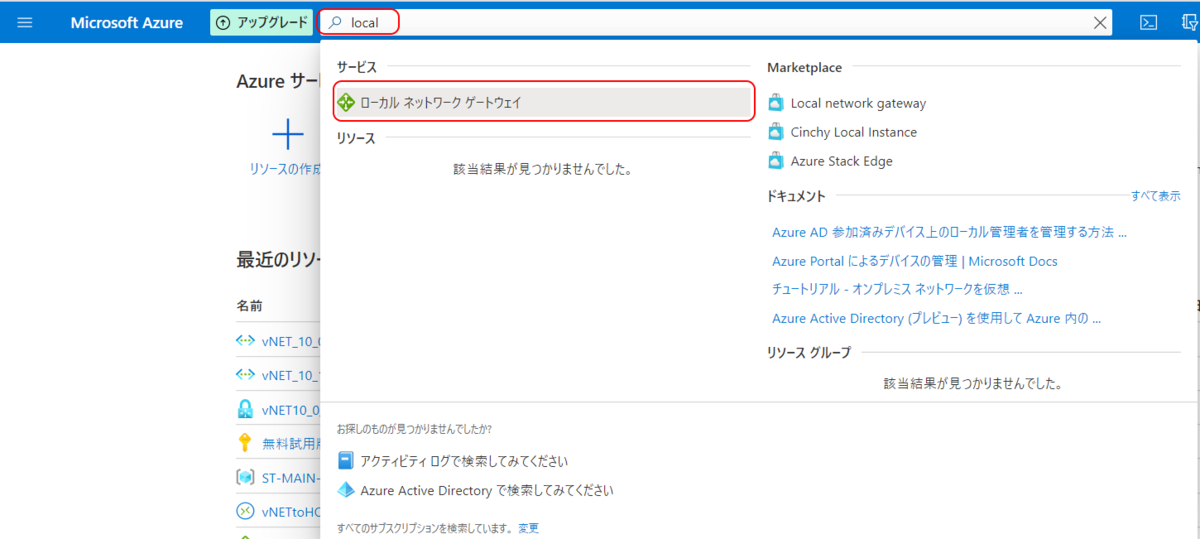

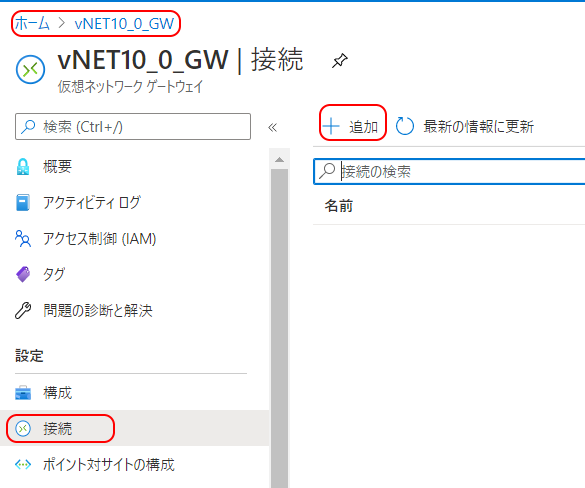

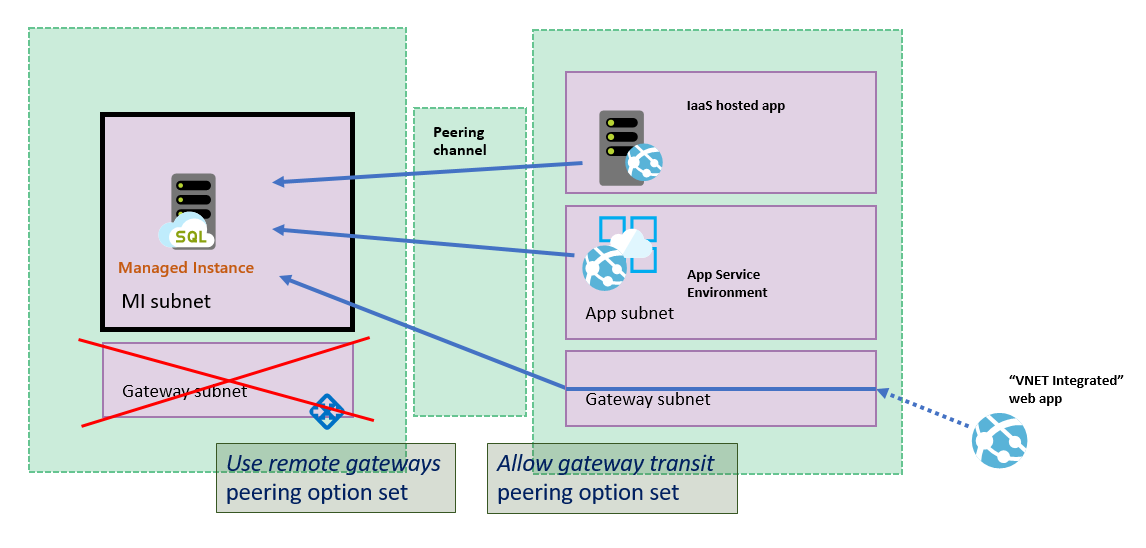

・AzureにvSocketを構築してCatoとつなぐ

【今後やること】

・いろいろなルーティング系の設定

・Azureに検証サーバーを建てて、遅延確認・ファイルコピー速度テストなどなど

・リモートアクセス

・セキュリティな制御

・WVDとのデザイン考察

ちょっと、Edge機器を借りようと思ったら出払っていると言われたので、兎に角クラウドにvSocketなポイントを建てていくしかないんだけどね。あと余力があればawsも試してみようかな。

細かくはキャプチャしたり手順は載せるつもりは無いのですが、大体の流れ~とか、ポイントになる部分とか、こんな感じーっていうのは伝わるように書いていきたいと思いまする。

肌感としては、ハイブリッドインフラにドップリでお疲れな方々に理解しやすいのかも?。クラウド特有の癖とロックインに対してどのようなアレンジで、どう向き合えるかがカギな気がします。

さて、がんばってキャプりますw

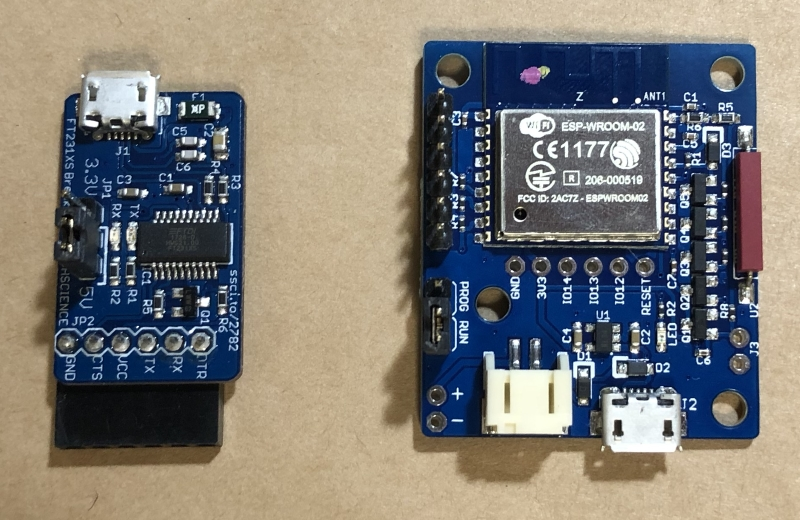

![[スイッチサイエンス] ESPr® Door Sensor [スイッチサイエンス] ESPr® Door Sensor](https://images-fe.ssl-images-amazon.com/images/I/51BBsIhHfdL._SL160_.jpg)

![[スイッチサイエンス] FTDI USBシリアル変換アダプター Rev.2 [スイッチサイエンス] FTDI USBシリアル変換アダプター Rev.2](https://images-fe.ssl-images-amazon.com/images/I/51i1FDzywpL._SL160_.jpg)